크로스 엔트로피와 딥러닝 모델의 원리 이해

F-Lab : 상위 1% 개발자들의 멘토링

AI가 제공하는 얕고 넓은 지식을 위한 짤막한 글입니다!

크로스 엔트로피와 정보량의 개념

크로스 엔트로피는 딥러닝에서 손실 함수로 자주 사용되는 개념으로, 정보 이론에서 유래되었습니다. 이는 두 확률 분포 간의 차이를 측정하는 데 사용됩니다. 크로스 엔트로피는 정보량의 기대값을 기반으로 하며, 정보량은 로그 함수로 정의됩니다.

왜냐하면 정보량은 확률이 낮을수록 더 많은 정보를 제공한다는 개념을 기반으로 하기 때문입니다. 이를 통해 크로스 엔트로피는 모델의 예측 분포와 실제 분포 간의 차이를 계산하는 데 유용합니다.

예를 들어, 크로스 엔트로피 손실 함수는 다음과 같이 정의됩니다:

H(p, q) = -Σ p(x) * log(q(x))

여기서 p는 실제 분포, q는 모델의 예측 분포를 나타냅니다. 이 함수는 모델이 잘못된 예측을 할수록 더 큰 손실 값을 반환합니다.

크로스 엔트로피는 특히 분류 문제에서 유용하며, 모델이 특정 클래스에 대해 높은 확률을 할당하도록 유도합니다. 이는 모델의 학습 과정에서 중요한 역할을 합니다.

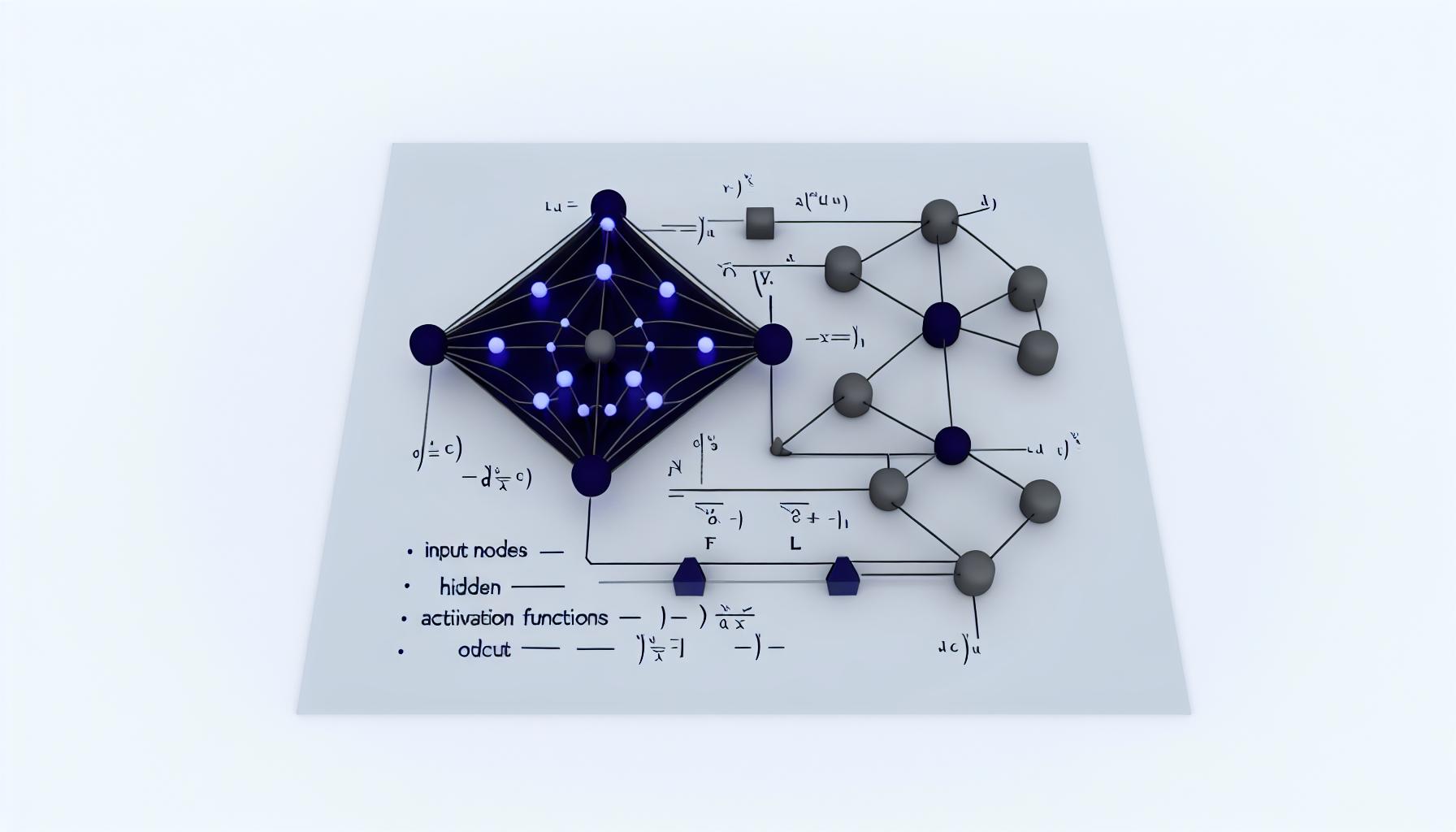

딥러닝 모델의 구조와 원리

딥러닝 모델은 뉴런과 뉴런 간의 연결로 이루어진 네트워크 구조를 가집니다. 각 뉴런은 입력 값을 받아 가중치와 곱한 후, 바이어스를 더해 출력 값을 생성합니다. 이 출력 값은 활성화 함수를 거쳐 다음 레이어로 전달됩니다.

왜냐하면 활성화 함수는 비선형성을 도입하여 모델이 복잡한 패턴을 학습할 수 있도록 돕기 때문입니다. 예를 들어, ReLU 함수는 다음과 같이 정의됩니다:

f(x) = max(0, x)

이 함수는 입력 값이 0보다 작으면 0을 반환하고, 그렇지 않으면 입력 값을 그대로 반환합니다. 이를 통해 모델은 비선형적인 관계를 학습할 수 있습니다.

딥러닝 모델의 학습 과정은 순전파와 역전파로 이루어집니다. 순전파는 입력 데이터를 네트워크를 통해 전달하여 출력 값을 계산하는 과정입니다. 역전파는 손실 값을 기반으로 가중치와 바이어스를 업데이트하는 과정입니다.

이 과정에서 옵티마이저가 사용되며, 일반적으로 아담(Adam) 옵티마이저가 많이 사용됩니다. 아담 옵티마이저는 학습 속도를 조정하고, 손실 값을 최소화하는 방향으로 파라미터를 업데이트합니다.

피드 포워드와 백 프로퍼게이션

피드 포워드(Feed Forward)는 입력 데이터를 네트워크를 통해 전달하여 출력 값을 계산하는 과정입니다. 이 과정에서 각 레이어의 뉴런은 입력 값을 받아 가중치와 곱하고, 바이어스를 더한 후 활성화 함수를 적용합니다.

왜냐하면 활성화 함수는 모델이 비선형적인 관계를 학습할 수 있도록 돕기 때문입니다. 예를 들어, 다음은 피드 포워드 과정의 코드 예제입니다:

def forward(x):

out = relu(np.dot(x, W1) + b1)

out = np.dot(out, W2) + b2

return out

백 프로퍼게이션(Back Propagation)은 손실 값을 기반으로 가중치와 바이어스를 업데이트하는 과정입니다. 이 과정은 편미분을 사용하여 손실 값에 대한 각 파라미터의 기울기를 계산합니다.

이 기울기는 옵티마이저에 의해 사용되며, 파라미터를 업데이트하여 손실 값을 최소화합니다. 예를 들어, 다음은 백 프로퍼게이션 과정의 코드 예제입니다:

def backward(loss):

grad_W2 = np.dot(hidden.T, loss)

grad_b2 = np.sum(loss, axis=0)

grad_hidden = np.dot(loss, W2.T) * relu_derivative(hidden)

grad_W1 = np.dot(x.T, grad_hidden)

grad_b1 = np.sum(grad_hidden, axis=0)

return grad_W1, grad_b1, grad_W2, grad_b2

이 과정을 통해 모델은 점진적으로 더 나은 예측을 할 수 있도록 학습합니다.

배치 처리와 GPU 활용

딥러닝 모델은 대량의 데이터를 처리하기 위해 배치(batch) 처리를 사용합니다. 배치 처리는 데이터를 여러 개의 작은 그룹으로 나누어 처리하는 방법입니다. 이를 통해 메모리 사용량을 줄이고, 연산 속도를 높일 수 있습니다.

왜냐하면 GPU는 병렬 연산에 최적화되어 있어, 배치 처리를 통해 여러 데이터를 동시에 처리할 수 있기 때문입니다. 예를 들어, 다음은 배치 처리를 사용하는 코드 예제입니다:

for batch in data_loader:

optimizer.zero_grad()

outputs = model(batch['inputs'])

loss = loss_function(outputs, batch['labels'])

loss.backward()

optimizer.step()

GPU는 쿠다(CUDA) 코어를 사용하여 병렬 연산을 수행합니다. 각 쿠다 코어는 독립적으로 연산을 수행하며, 이를 통해 대량의 데이터를 빠르게 처리할 수 있습니다.

배치 크기는 GPU의 메모리 용량과 쿠다 코어의 개수에 따라 조정됩니다. 일반적으로 배치 크기가 클수록 연산 속도가 빨라지지만, 메모리 사용량도 증가합니다.

따라서 적절한 배치 크기를 선택하는 것이 중요합니다. 이는 모델의 성능과 학습 속도에 큰 영향을 미칩니다.

크로스 엔트로피와 소프트맥스의 역할

크로스 엔트로피 손실 함수는 소프트맥스(Softmax) 함수와 함께 사용됩니다. 소프트맥스 함수는 모델의 출력 값을 확률 분포로 변환합니다. 이를 통해 각 클래스에 대한 확률을 계산할 수 있습니다.

왜냐하면 소프트맥스 함수는 출력 값의 합이 1이 되도록 정규화하기 때문입니다. 예를 들어, 다음은 소프트맥스 함수의 정의입니다:

def softmax(x):

exp_x = np.exp(x - np.max(x))

return exp_x / np.sum(exp_x, axis=0)

크로스 엔트로피 손실 함수는 소프트맥스 함수의 출력 값을 사용하여 모델의 예측과 실제 값 간의 차이를 계산합니다. 이를 통해 모델은 더 정확한 예측을 할 수 있도록 학습합니다.

소프트맥스 함수는 또한 모델의 출력 값을 해석 가능하게 만듭니다. 예를 들어, 특정 클래스에 대한 확률이 가장 높은 경우, 해당 클래스를 모델의 예측으로 간주할 수 있습니다.

이러한 특성은 분류 문제에서 매우 유용하며, 모델의 성능을 평가하는 데 중요한 역할을 합니다.

결론: 딥러닝 모델의 이해와 응용

이번 글에서는 크로스 엔트로피와 딥러닝 모델의 원리에 대해 알아보았습니다. 크로스 엔트로피는 정보 이론에서 유래된 개념으로, 모델의 예측과 실제 값 간의 차이를 측정하는 데 사용됩니다.

딥러닝 모델은 뉴런과 뉴런 간의 연결로 이루어진 네트워크 구조를 가지며, 순전파와 역전파를 통해 학습합니다. 이 과정에서 활성화 함수와 옵티마이저가 중요한 역할을 합니다.

또한, 배치 처리를 통해 대량의 데이터를 효율적으로 처리할 수 있으며, GPU를 활용하여 연산 속도를 높일 수 있습니다. 소프트맥스 함수는 모델의 출력 값을 확률 분포로 변환하여 해석 가능하게 만듭니다.

이러한 개념들은 딥러닝 모델을 설계하고 학습시키는 데 필수적입니다. 이를 바탕으로 다양한 문제를 해결할 수 있는 모델을 개발할 수 있습니다.

앞으로도 딥러닝의 원리를 깊이 이해하고, 이를 실제 프로젝트에 응용하는 데 도움이 되길 바랍니다.

이 컨텐츠는 F-Lab의 고유 자산으로 상업적인 목적의 복사 및 배포를 금합니다.